|

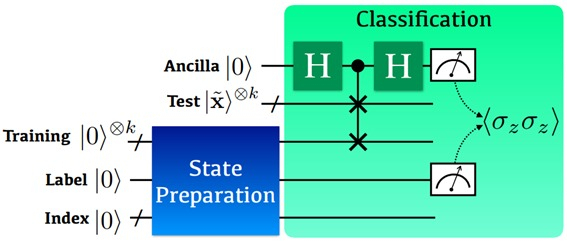

| 연구팀이 개발한 양자 커널기반 지도학습의 양자회로도 예시.[KAIST 제공] |

[헤럴드경제=구본혁 기자] 한국과학기술원(KAIST)은 전기및전자공학부 및 AI 양자컴퓨팅 IT 인력양성연구센터 이준구 교수 연구팀이 독일 및 남아공 연구팀과의 협력 연구를 통해 비선형 양자 기계학습 인공지능 알고리즘을 개발했다고 7일 밝혔다.

이준구 교수팀은 학습데이터와 테스트데이터를 양자 정보로 생성한 후 양자 정보의 병렬연산을 가능하게 하는 양자포킹 기술과 간단한 양자 측정기술을 조합해 양자 데이터 간의 유사성을 효율적으로 계산하는 비선형 커널 기반의 지도학습을 구현하는 양자 알고리즘 체계를 만들었다. 이후 IBM 클라우드 서비스를 통해 실제 양자컴퓨터에서 양자 지도학습을 실제 시연하는 데 성공했다.

기계학습에 있어 중요한 문제 중 하나는 주어진 데이터의 특징(feature)을 구분해 분류하는 것이다. 간단한 예로 동물 이미지 학습데이터에서 입, 귀 등의 특징을 바탕으로 분류하기 위한 결정 경계를 학습하고 새로운 이미지가 입력되었을 때 개 또는 고양이로 분류하는 작업을 생각해볼 수 있다. 데이터의 특징들이 잘 나타나는 경우에는 선형적 결정 경계만으로 분류할 수 있다. 그러나 입과 귀 모양의 특징으로만 개와 고양이를 분류하기 쉽지 않다면 새로운 결정 경계를 찾기 위해 특징에 관한 정보 공간의 차원을 확장해야 하는데 이러한 과정에서 비선형 커널 기술이 필요하다.

양자컴퓨팅은 고전 컴퓨팅과는 달리 큐비트(양자컴퓨팅 정보처리의 기본 단위)의 개수에 따라 정보 공간의 차원이 기하급수적으로 증가하기 때문에 이론적으로 고차원 정보처리에 있어 기하급수적으로 뛰어난 성능을 낼 수 있다.

연구팀은 이러한 양자컴퓨팅의 장점을 활용해 데이터 특징 대비 기하급수적인 계산 효율성을 달성하는 양자 기계학습 알고리즘을 개발했다. 이 교수 연구팀이 개발한 이 알고리즘은 저차원 입력 공간에 존재하는 데이터들을 큐비트로 표현되는 고차원 데이터 특징 공간으로 옮긴 후, 양자화된 모든 학습데이터와 테스트데이터 간의 커널 함수를 양자 중첩을 활용해 동시에 계산하고 테스트데이터의 분류를 효율적으로 결정한다. 이때 사용되는 양자 회로의 계산 복잡도는 학습 데이터양에 대해서는 선형적으로 증가하나, 데이터 특징 개수에 대해서는 불과 로그(log)함수로 매우 천천히 증가하는 장점이 있다.

연구팀은 이와 함께 양자 회로의 체계적 설계를 통해 다양한 양자 커널 구현이 가능함을 이론적으로 증명했다. 커널 기반 기계학습에서는 주어진 입력 데이터에 따라 최적 커널이 달라질 수 있으므로, 다양한 양자 커널을 효율적으로 구현할 수 있게 된 점은 양자 커널 기반 기계학습의 실제 응용에 있어 매우 중요한 성과다.

연구팀은 IBM이 클라우드 서비스로 제공하는 다섯 개의 큐비트로 구성된 초전도 기반 양자 컴퓨터에서 이번에 개발에 성공한 양자 기계학습 알고리즘을 실험적으로 구현해냈다.

공동 1저자인 박경덕 KAIST 연구교수는 "연구팀이 개발한 커널 기반 양자 기계학습 알고리즘은 수년 안에 상용화될 것으로 예측되는 수 백 큐비트의 NISQ 컴퓨팅 시대가 되면 기존의 고전 커널 기반 지도학습을 뛰어넘을 것으로 기대된다ˮ면서 "복잡한 비선형 데이터의 패턴 인식 등을 위한 양자 기계학습 알고리즘으로 활발히 사용될 것ˮ이라고 말했다.

이번 연구결과는 국제학술지 네이처 자매지인 ‘npj 퀀텀 인포메이션’ 5월호에 게재됐다.

nbgkoo@heraldcorp.com